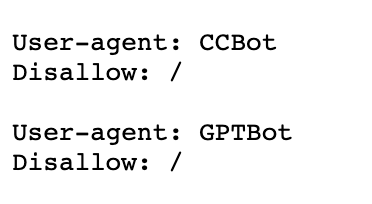

Sono apparse due nuove voci nelle specifiche di scansione, in precedenza piuttosto liberali, del robots.txt del New York Times: sia il Web Index CommonCrawl (“CCBot”) che il Web Crawler OpenAI (“GPTBot”) non sono più autorizzati ad accedere ai contenuti del giornale.

Secondo alcune indiscrezioni, nelle ultime settimane il NYT ha cercato di raggiungere un accordo con OpenAI riguardo all’utilizzo dei suoi contenuti, senza riuscirci, e ora starebbe addirittura pensando d’intentare causa contro OpenAI. Dopo l’euforia iniziale per l’IA generativa, sta lentamente diventando evidente che l’Open Web potrebbe essere la parte svantaggiata dallo sviluppo dell’IA.

La motivazione per l’offerta di contenuti disponibili pubblicamente su internet è stata finora chiara: l’attenzione e la visibilità hanno portato direttamente o indirettamente a ricavi, rendendo così lo sforzo economicamente interessante per il fornitore.

Negli ultimi anni, Google ha cercato di spostare questo tacito accordo a proprio favore attraverso varie ricerche verticali o addirittura i Featured Snippet. Le nuove possibilità offerte dall’intelligenza artificiale stanno ora accelerando questo processo: non è infatti più necessario visitare un sito perché l’AI lo fa per l’utente.

Il grande svantaggio dal punto di vista dei webmaster: l’IA non clicca sugli annunci, non acquista abbonamenti e, purtroppo, ha pochi altri vantaggi dal punto di vista commerciale. Al più tardi quando Google lancerà la Search Generative Experience, il conflitto diventerà evidente e costituirà un serio problema per molti modelli di business nel web.